AI 大模型官网的安全性如何保障

AI 大模型的安全性保障是一个复杂且多方面的问题。OpenAI 曾在其官方博客发布文章回应外界对其 AI 模型安全性的质疑,介绍了包括构建日益安全的 AI 系统、在实际使用中学习改进安全措施、保护儿童、尊重隐私、提高事实准确性,以及持续研究和参与等六个方面的安全部署。例如要求用户必须年满 18 周岁,或在父母同意的情况下年满 13 周岁才能使用 AI 工具,不允许其技术被用于生成仇恨、骚扰、暴力或成人内容等。此外,亚马逊云科技强调数据治理流程贯穿生成式 AI 全周期,防止数据泄露与篡改是关键。其构建了一套名为 “Well-Architected Framework” 的整体方法论,其中安全支柱明确了如何保护存储中的数据,如实施安全密钥管理、静态数据保护自动化、实施访问控制、利用机制限制数据访问等。

同时,为确保大模型的安全和负责任地使用,各国的监管机构都在积极探讨并制定相应的安全标准和准则,为开发者和企业提供清晰的大模型应用和治理方向。在大模型的备案方面,根据《生成式人工智能服务安全基本要求》,需提供语料安全、模型安全、安全措施,以及以上的安全自评估等材料。

然而,AI 大模型仍面临诸多潜在的安全风险。大模型较为脆弱,对安全风险的防范能力不足,容易受到指令攻击、提示注入和后门攻击等恶意攻击。在应用中,可能会产生与人类价值观不一致的输出,如歧视言论、辱骂、违背伦理道德的内容等。大模型在数据准备、预训练、微调对齐、推理以及应用阶段都会存在各种潜在的风险。总之,保障 AI 大模型官网的安全性需要多方面的努力和措施。

OpenAI 的 AI 大模型安全部署措施

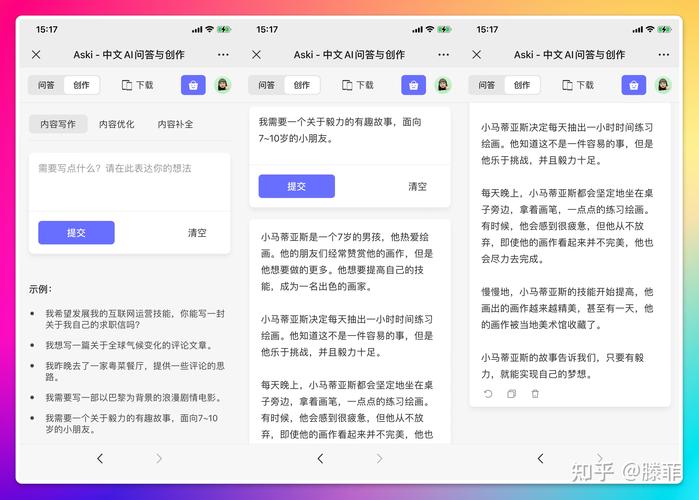

OpenAI 致力于确保其 AI 大模型的安全性。其安全系统团队处于前沿,通过多种方式来保障安全。在模型行为方面,聚焦创建更安全、符合价值观、可靠和可控的模型。通过安全工程,将系统级的安全措施落实到产品上,构建安全、有隐私意识的集中式服务基础设施,并创建面向机器学习的工具。安全推理研究用于检测和理解风险,指导默认安全模型行为和缓解措施的设计。人机交互方面,通过政策设计将模型行为与期望的人类价值接口,人类专家提供反馈,确保在各个阶段与人类期望的接触。此外,OpenAI 还致力于解决诸如避免模型给出不安全或不适当的答案、检测有害答案或操作、维护用户隐私等安全问题,并强调以模型行为一致性为核心的研究。

亚马逊云科技保障大模型安全的数据治理流程

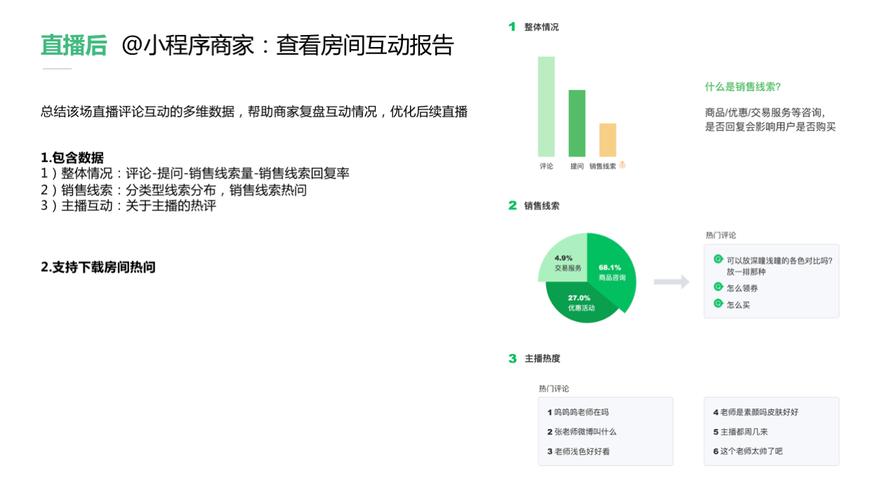

亚马逊云科技在大数据和人工智能领域经验丰富,提供了全面的数据治理流程来保障大模型安全。从数据源的采集到智能湖仓的数据分析和处理,再到将分析结果安全地传送到 AI 平台进行训练、调优和推理,整个链路上的数据分类和治理都得到完善支持。对于存储中的数据,采用加密技术防止数据泄露和篡改,提供安全密钥的证书管理,严格控制访问权限。在数据传输过程中,使用安全协议加密数据,采用虚拟化层的硬件加速和隔离运算环境等技术增加安全性。在使用数据时,提供解决方案管理和保护敏感数据。

各国监管机构制定的大模型安全标准和准则

随着 AI 大模型的广泛应用,各国监管机构积极制定相应的安全标准和准则。例如,国际组织 WDTA 发布了《生成式人工智能应用安全测试标准》和《大语言模型安全测试方法》两项国际标准,由 OpenAI、蚂蚁集团、科大讯飞、谷歌、微软、英伟达、百度、腾讯等众多单位的专家学者共同编制。这些标准为测试和验证生成式 AI 应用的安全性提供了框架,规定了人工智能应用程序架构每一层的测试和验证范围,确保应用程序运行能持续 正在加载更多深度信息

版权声明

本文由ChatGPT生成,图片来源互联网,如有侵权,请联系删除

haoxyz

haoxyz

发表评论