AI自动写作平台模型制作:从RNN到Transformer的技术演变

你是否曾经对那些自如生成文章的 AI 感到惊叹不已?它们的背后,隐藏着一种神秘的科技魔法。从最初的“编程大师”到如今的“写作天才”,AI 自动写作平台经历了怎样的技术蜕变?今天,我们将带你揭开这段从 RNN 到 Transformer 的神奇旅程,让你一窥这场写作技术的华丽演变!

1. 从 RNN 的起步,到高效的 Transformer

在 AI 写作的早期阶段,循环神经网络(RNN)是主角。RNN 擅长处理序列数据,它通过“记住”之前的信息来预测下一个词。这种“记忆”让 RNN 能够生成连贯的文本,但随着输入数据的增加,RNN 的“记忆”能力也开始显得捉襟见肘。要知道,RNN 在长文本生成中的短期记忆限制,就像是你记住了一句笑话,却忘记了笑点。

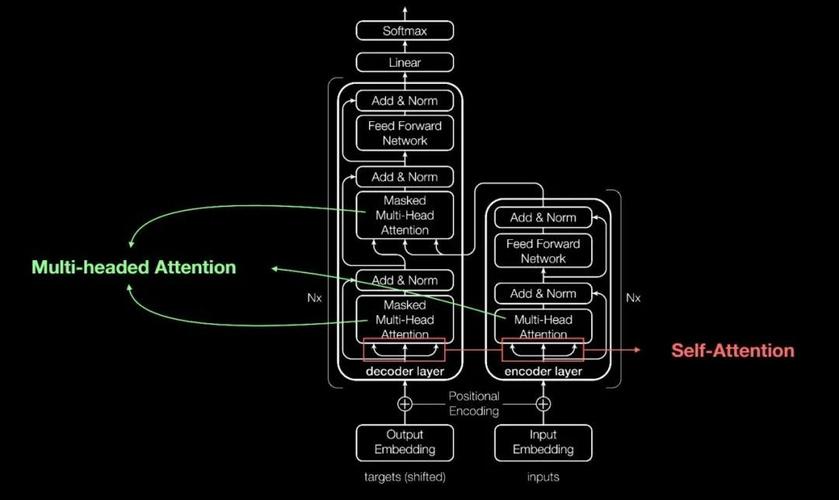

接着,Transformer 技术的出现彻底改变了局面。它引入了注意力机制,能够并行处理数据,从而大幅提高了生成速度和质量。Transformer 就像是一个记性超群的超级秘书,不仅记住了你说过的每一句话,还能迅速找到最重要的信息,让写作变得更加高效和精准。

2. 构建 AI 写作模型的核心技术

构建一个 AI 自动写作模型,首先要选择合适的技术架构。传统的 RNN 模型虽然在处理短文本时效果不错,但面对复杂的长文本时却显得力不从心。于是,深度学习领域的明星——Transformer 上场了。Transformer 的设计理念是将注意力机制引入序列处理,使得模型能够同时关注输入的不同部分,提高了生成的灵活性和准确性。

在模型搭建时,你需要设置模型的层数、神经元数量等参数。例如,在使用 Keras 搭建一个语言模型时,可以选择嵌入层、双向 GRU 层和全连接层的组合,来处理输入的文本数据。这些层次的设置,就像是为你的 AI 写作助手量身定做的工具箱,让它可以灵活应对各种写作任务。

3. 数据的重要性:训练模型的基石

制作 AI 自动写作模型,数据的质量至关重要。高质量的数据不仅要有代表性,还要真实、准确,没有错误或缺失。大量的文本数据,像是从小说、新闻、博客中提取的,都将成为训练模型的基础。清洗和预处理这些数据,使之适合模型的输入,是模型训练的重要步骤。

此外,数据的多样性也是关键。例如,训练一个小说生成模型,你需要各种题材、风格的小说数据;而训练新闻生成模型,则需要不同领域的新闻报道。数据的丰富性和多样性,能帮助模型更好地适应不同的写作场景和需求。

4. 优化和调整:让模型更聪明

在模型的优化调整中,明确的写作目标至关重要。清楚你想要传达的信息、目标受众和预期效果,可以帮助你更好地调整模型的设置和参数。通过结合人工智能与人工智慧的优势,对生成内容进行人工编辑和修改,确保文采和逻辑结构的完善,也是提升写作质量的有效手段。

为了保持内容的创新性和吸引力,优化过程还需关注创意的加入。比如,通过智能标题生成功能,预测热门话题和关键词,生成更具吸引力的标题;或是优化段落结构,使文章更流畅自然,提升读者的阅读体验。

5. 未来展望:从模型到应用的无限可能

AI 自动写作平台模型的技术演变,展示了深度学习和自然语言处理领域的巨大进步。从最初的 RNN 到如今的 Transformer,这些技术的进步不仅提升了文本生成的质量和效率,也为用户带来了更多的便利和创意可能。未来,随着技术的不断发展和应用场景的拓展,AI 写作平台将会更加智能和多样化,为我们带来更加惊艳的写作体验。

AI 自动写作平台的进步,让写作变得更加高效和智能。了解这些技术演变,不仅能让你更好地使用这些工具,还能让你在未来的写作中,充分发挥它们的强大潜力。

版权声明

本文由ChatGPT生成,图片来源互联网,如有侵权,请联系删除

haoxyz

haoxyz

发表评论