关于ai人工智能的论文

以下为您提供一些关于 AI 人工智能的论文相关信息。近年来,AI 人工智能领域的研究成果丰硕。例如,在模型架构改进方面,自 2010 年代以来,包括 AlexNet 在深度卷积神经网络方面的工作,以及备受赞誉的论文《Attention is all you need》等,推动了重大突破和初创企业创新。在开发人员生产力提升方面,工具和框架如 TensorFlow、PyTorch、HuggingFace Transformers 库,以及 Meta 开源的 Llama 模型等,显著提高了开发人员的工作效率。

在任务表现的优化方面,多篇论文改变了人工智能执行任务的效率和多样性,如在训练深度神经网络执行复杂任务、联合学习进行对齐和翻译等方面。在计算优化方面,2010 年代的 dropout 和批量归一化等新的优化技术提高了模型性能和稳定性。

此外,关于人工智能的论文还涵盖了多个具体方向。比如在神经网络基础部分,有 wide_deep 模型论文,将 wide 模型和 deep 模型结合,综合二者优点以获得更好的结果;还有关于 Adam 优化算法的论文,深入探讨其原理。在图像分类部分,有 Xception 模型论文、残差结构论文、空洞卷积论文、DenseNet 论文等,这些研究成果在推动图像分类技术发展方面发挥了重要作用。

在自然语言处理方面,也有诸多研究成果。如深度学习在情感分析任务中的应用,以及通过长序列摘要生成维基百科等。同时,还有研究探讨了大型语言模型如 GPT-4 的能力和局限性,以及具体体现语言模型如 PaLM-E 在解决机器人问题等实际场景中的应用。

总之,AI 人工智能领域的论文丰富多样,不断推动着技术的进步和创新。

AI 人工智能模型架构改进的研究

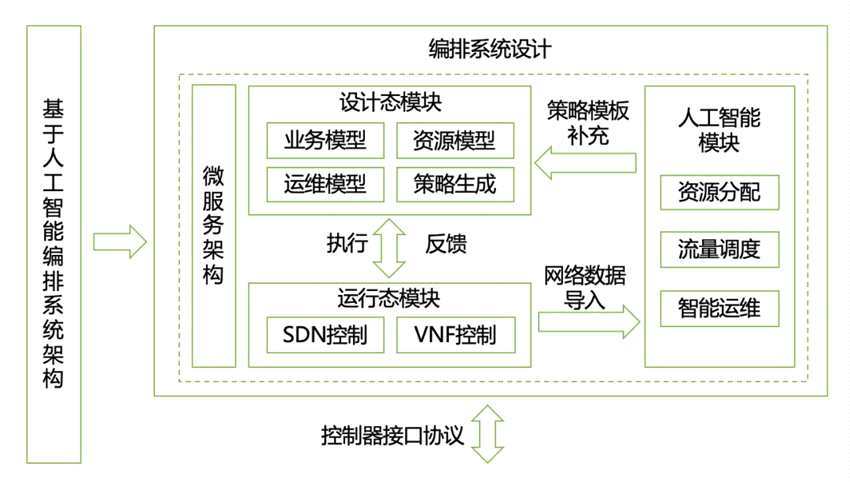

随着人工智能技术的迅速发展,模型架构的改进成为推动其进步的关键因素之一。自 2010 年代以来,这方面的研究取得了显著突破。例如,AlexNet 在 2012 年的深度卷积神经网络工作,为图像识别等领域带来了巨大变革。它通过引入更深的网络层次和创新的卷积结构,大幅提高了模型的性能和准确性。再如,备受赞誉的论文 “Attention is all you need” 彻底改变了自然语言处理,其提出的注意力机制让模型能够更加灵活地关注输入序列中的不同部分,从而更好地捕捉语义信息。此外,还有许多研究致力于优化模型的结构,如减少参数数量、提高计算效率等,以适应不同的应用场景和硬件条件。

在模型架构改进的研究中,不仅有对传统神经网络结构的优化,还有对新型架构的探索。例如,一些研究尝试将图神经网络、生成对抗网络等与传统架构相结合,创造出更具表现力和适应性的模型。同时,为了应对大规模数据和复杂任务的需求,模型的并行化和分布式训练技术也在不断发展,使得训练更高效、更快速。

AI 执行任务表现的优化成果

在 AI 执行任务表现的优化方面,取得了诸多显著成果。例如,通过对人工智能角色所执行的任务使用原子行为进行替代,并对单一任务行为进行单一化处理,删除关联性行为,能够有效减少设计人工智能行为的复杂度。同时,在执行任务前进行搜索替换和多任务的算法处理,使得人工智能在执行多个任务时,能够通过算法计算得出最优执行流程和对应的行为组合,并根据计算结果执行任务,从而提高任务执行的效率和准确性。

此外,对于具有多个重叠行为的任务进行单一化处理,能够避免重复计算和资源浪费。在人工智能执行任务时,对所执行的任务进行关联查询,删除对任务结果没有影响的相关性任务和行为处理动作,能够进一步提高执行效率。这些优化成果不仅在游戏开发等特定领域发挥了重要作用,在其他需要高效执行任务的场景中也具有广泛的应用前景。

AI 计算优化的新技术

AI 计算优化的新技术不断涌现,为人工智能的发展提供了强大支持。在能效优化的硬件设计方面,针对 AI 应用场景的特点,设计了能效更高的专用 AI 芯片和处理器,如 ASIC 和 FPGA 等。这些定制化的硬件能够有效减少能源浪费,提高计算效率。

在模型压缩与量化方面,通过剪枝、量化、知识蒸馏等方法,能够减小深度学习模型的规模,降低其计算和存储需求。例如,在图像分类任务中,经过量化处理的模型可以在不损失太多精度的情况下,大大减少计算量和存储空间。

低能耗推理技术的发展也为 AI 计算优化带来了新的突破。基于稀疏计算、近似计算等技术的低能耗推理框架,能够在边缘设备上实现高效的 AI 推理,减少对中心数据中心的依赖。例如,在智能物联网设备中,利用这些技术可以实现实时的数据分析和决策,同时降低能耗。

AI 神经网络基础的研究

AI 神经网络基础的研究是人工智能领域的重要组成部分。神经网络是一种模拟人类大脑结构和工作原理的计算模型,由多个相互连接的节点(称为神经元或单元)组成。神经元是神经网络中的基本单元,它接收输入信号,通过权重和偏置进行处理,并输出结果。激活函数决定了神经元输出的形式,常见的激活函数有 sigmoid、tanh 或 ReLU 等。

损失函数用于衡量模型预测与实际值之间的差异,是训练神经网络的关键。常见的损失函数如均方误差(MSE)或交叉熵损失等。反向传播是训练神经网络的重要步骤,通过计算梯度来调整权重和偏置,以最小化损失函数。优化算法如梯度下降、随机梯度下降、动量、RMSprop 等则用于更新神经网络的权重和偏置。

人工神经网络还对生物神经系统进行了模拟,其信息处理功能由网络单元的输入输出特性、网络的拓扑结构、连接权大小和神经元的阈值等 正在加载更多深度信息

版权声明

本文由ChatGPT生成,图片来源互联网,如有侵权,请联系删除

haoxyz

haoxyz

发表评论