如何评估不同 AI 自动生成代码系统的效率?

评估不同 AI 自动生成代码系统的效率可以从以下几个方面入手:准确性方面,通过比较模型预测值与真实值的差异来衡量。常见的准确性指标有准确率、精确度和召回率。准确率是指模型在所有样本中正确预测的比例,公式为 Accuracy = (TP + TN) / (TP + TN + FP + FN)。精确度是指模型在所有预测为正例的样本中,实际为正例的比例,公式为 Precision = TP / (TP + FP)。召回率是指模型在所有实际为正例的样本中,正确预测的比例,公式为 Recall = TP / (TP + FN)。

效率方面,常见的效率评估指标包括吞吐量和延迟。吞吐量是指模型在单位时间内处理的样本数量,公式为 Throughput = Number of samples processed / Time taken。延迟是指模型从接收输入到生成预测值所消耗的时间,公式为 Latency = Time taken。

稳定性方面,常见的稳定性评估方法有交叉验证和参数搜索。交叉验证是指在不同的训练集和测试集组合下,重复训练和测试模型,以评估模型的稳定性。参数搜索是指在不同参数设置下,对模型性能进行评估,以找到最佳参数组合。

在实际评估中,可以使用不同的代码生成系统完成相同的任务,例如生成特定功能的代码段或完整的程序。然后从代码的质量,包括结构、逻辑、命名规范、注释和可读性等方面进行评估。还可以比较开发时间、工作量和代码重用程度等指标来衡量开发效率。

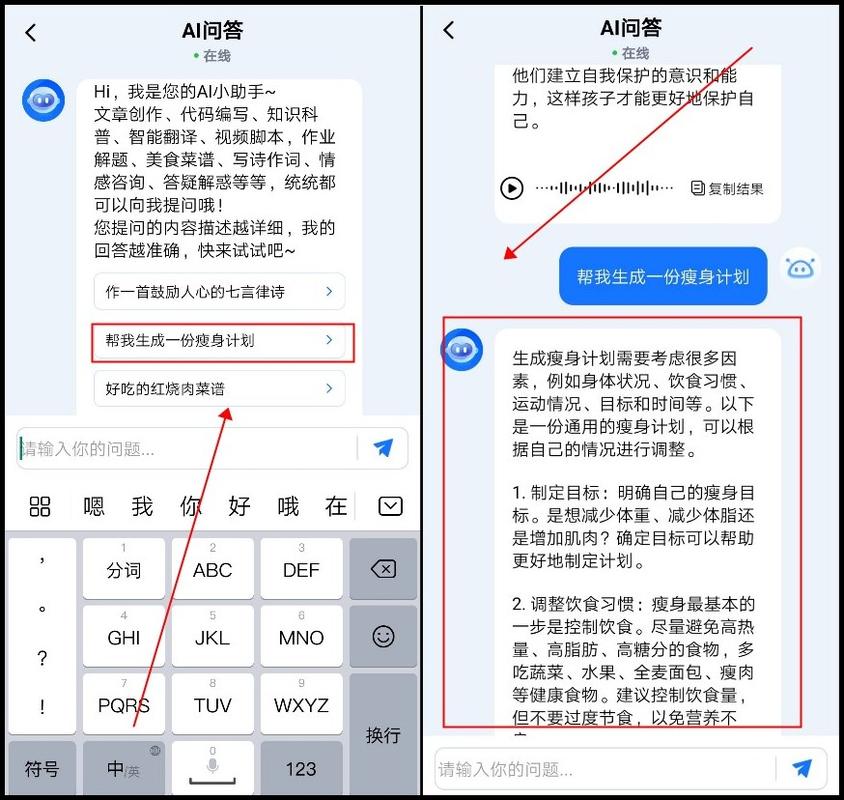

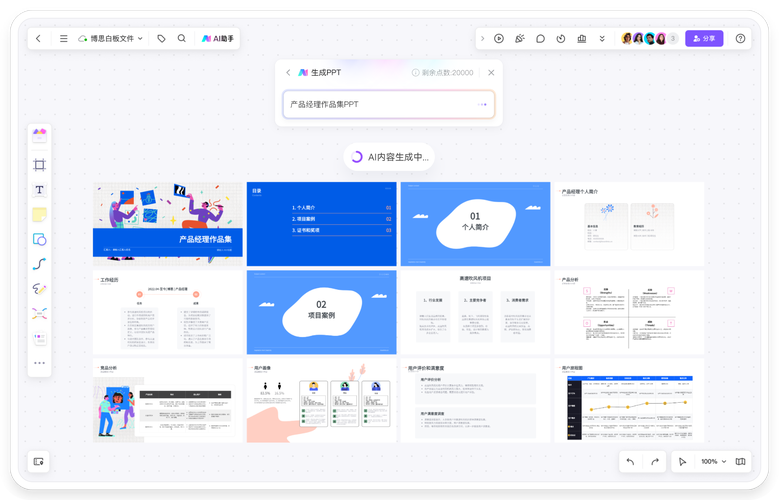

在实际评估中,可以使用不同的代码生成系统完成相同的任务,例如生成特定功能的代码段或完整的程序。然后从代码的质量,包括结构、逻辑、命名规范、注释和可读性等方面进行评估。还可以比较开发时间、工作量和代码重用程度等指标来衡量开发效率。 例如,GitHub Copilot 发布还不到两年,就已经为 100 多万的开发者编写了 46% 的代码,并提高了 55% 的编码速度。而新一代的 GitHub Copilot X 更是整合了聊天界面,不仅能生成代码,还能边写代码边对话,其新功能由 OpenAI 的 GPT-4 驱动。但值得注意的是,由于速度延迟的原因,代码自动补全工具仍基于 GitHub 的 Codex 模型上。

此外,还可以通过单元测试来评估生成代码的功能正确性。比如假设生成一个计算斐波那契数列的函数,通过编写测试代码来验证其结果是否正确。同时,也要考虑代码风格和可读性,确保生成的代码符合代码风格指南且易于阅读和理解。

AI 自动生成代码系统效率的评估指标

在评估 AI 自动生成代码系统的效率时,需要考虑多个关键指标。首先是吞吐量,它指的是模型在单位时间内处理的样本数量。例如,如果一个 AI 系统在一小时内能够生成 1000 段代码,那么其吞吐量就是 1000 段 / 小时。通过比较不同系统的吞吐量,可以直观地了解它们在单位时间内的工作能力。

延迟也是重要的评估指标之一。延迟是指模型从接收输入到生成预测值所消耗的时间。比如,当用户向一个 AI 生成代码系统提出需求后,系统在 5 秒内给出了生成的代码,那么这个 5 秒就是延迟时间。较短的延迟意味着系统能够更快地响应用户的需求,提高开发的效率。

在实际应用中,不同的场景对效率的要求也有所不同。对于一些大规模的项目开发,可能更注重高吞吐量,以快速生成大量的代码。而对于实时性要求较高的应用,如在线编程助手,低延迟则显得更为关键。

此外,还需要考虑系统在不同规模和复杂程度的任务中的表现。有些系统在处理简单任务时效率很高,但面对复杂的代码生成需求时可能会出现性能下降的情况。

总之,评估 AI 自动生成代码系统的效率需要综合考虑吞吐量、延迟等指标,并结合具体的应用场景和任务需求来进行全面的分析。

AI 自动生成代码系统稳定性的评估方式

AI 自动生成代码系统的稳定性评估是确保其可靠运行的重要环节。稳定性评估可以通过交叉验证来实现。即在不同的训练集和测试集组合下,重复训练和测试模型,观察其性能的变化。例如,将数据集随机划分为多个子集,然后依次使用不同的子集组合进行训练和测试,若模型在各种组合下的表现差异较小,说明其稳定性较好。

参数搜索也是评估稳定性的常见方法之一。通过在不同参数设置下对模型性能进行评估,找到最佳参数组合。如果在不同参数下,模型的性能波动较小,表明其稳定性较高。

此外 正在加载更多深度信息

版权声明

本文由ChatGPT生成,图片来源互联网,如有侵权,请联系删除

haoxyz

haoxyz

发表评论